Технологический кризис ИТ в 2020-25.

Семенов Ю.А.(ИТЭФ-МФТИ)

За последние годы реализован потрясающий прогресс в информационных технологиях. За 20 лет увеличилось быстродействие вычислительной техники

в 1000 раз, пропускная способность каналов возросла в 10000 раз, уже около 30 лет действует закон Мура (удвоение плотности активных элементов

на кристалле каждые полтора года). Уместно задать вопрос – можно ли ожидать аналогичный темп развития в дальнейшем?

К сожалению, ответ на этот вопрос будет, скорее всего, отрицательным, если ориентироваться на существующие технологии.

Прогресс в области цифрового ТВ и DVD-видео был связан с повышением эффективности сжатия информации. Алгоритмы сжатия данных без потерь вышли

на энтропийный предел еще около 10 лет назад. Используемая технология на кремнии, позволяет работать с разрешением ~15 нм. На подходе мемристоры и графеновые

транзисторы (5 нм), но постоянная кристаллической решетки кремния ~0,1нм. Да и совместить технологию на кремнии с графитом будет не просто.

Понятно, что запас повышения разрешения менее 10, и это ограничение не технологии, а физики.

Наиболее скоростные каналы передачи данных (оптоволоконные) работают на скорости 1011 бит/c (используется 16 потоков в одном волокне),

а постоянная поляризации диэлектрика составляет 10-13 сек (запас на 5 лет развития с тем же темпом). За счет

l-коммутации можно увеличить скорость передачи еще в 5-10 раз.

Рост тактовых частот процессоров замедлился и уже в 2004 году производители перешли на многоядерную схему. Но и здесь ресурсы

не беспредельны – уже сегодня на кристалле около 70% поверхности занимают проводные соединения между активными элементами,

да и делать кристаллы размером с книгу вряд ли можно считать целесообразным. Кроме того, производительность вычислений растет

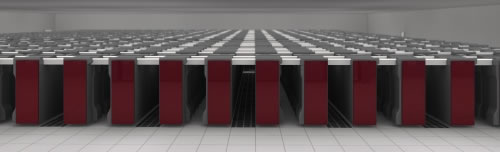

в среднем пропорционально логарифму числа процессоров. Ярким примером сложившейся ситуации может служить супер-ЭВМ рекордсмен (Япония;

10 петафлоп/c), которая занимает 800 стоек и требует для своего питания и охлаждения отдельной электростанции (5 МВт = мощности первой АЭС в Обнинске; см. рис. ниже).

А это самая энергоэффективная машина на сегодняшний день (2,2 Гфлопс/Вт). Что ждать от супер-ЭВМ следующего поколения – машина размером с небольшой город?

Вычислительные машины в 2005 году потребляли 1,2-1,5% производимой энергии (в США), большая часть из этой доли приходится на настольные машины и небольшие серверы. Но было принято решение сократить потребление в 2 раза.

Эта задача была решена, что дало толчок к формированию направления green computing.

Предполагается, что критических значений технологии достигнут в 2020-25 годах. Число машин, подключенных к Интернет, достигло 1,5 млрд.

Вместе с iPhone, iPad и пр. это число достигает 4 млрд. Человечество уже не может жить без машин и сетей. Машины управляют потенциально опасными технологиями,

авиалайнерами, энергетическими системами, проектируют новые лекарства, на очереди встраивание чипов в организм человека и т.д. Но ведь машины и используемые ими каналы передачи данных

имеют конечную надежность. Среднее число ошибок на 1000 строк кода равно 15-50. Для Linux это число равно 7. Продукты Microsoft после отладки характеризуются цифрой 0,5 ошибок на 1000 строк кода.

Рекордное значения имеют программные продукты NASA JPL (навигационные программы для космических объектов) имеют 0.003 ошибки на 1000 строк кода.

В программном обеспечении любой современной машины содержится до 50000 ошибок. По этой причине жизненно важным становится поиск решений, которые бы гарантировали приемлемый результат даже на ненадежной машине

с ошибками в программном обеспечении. Согласно существующим оценкам в дистрибутиве Debian содержится около 3 миллионов ошибок (на 350 млн. строк кода)!

Быстро растет объем информации. Журнал Economist оценивает, что объем данных каждый год увеличивается на 60%.

Эта точка зрения подтверждается аналитиком компании IDC, который предсказывает, что ‘цифровая вселенная’ вырастит до 1.8 зеттабайт

(1021байт) в 2011, на 47% по отношению к 2010, и превысит 7 ZB к 2015. 1 зеттабайт эквивалентен содержимому 50

библиотек конгресса США. На рис. 1 показан рост информационных объемов и доступной памяти. Зазор между потребностями и возможностями

со временем только увеличивается (200 петабайт в год).

Рис.1. Рост потребности и возможности памяти

Дело идет к тому, что любая информация, как хранимая, так и передаваемая будет криптографически защищена. Но для алгоритмов защиты не

доказаны теоремы криптографической прочности, а современные вычислительные технологии, в частности графические процессоры, сокращают

срок жизни криптографических ключей. С учетом этого обстоятельства кривые на рис. 2 можно опустить вниз на 10 единиц.

Рис. 2. Время жизни криптографических алгоритмов

На рис. 3 показана эволюция числа WEB-серверов по годам с января 1996 по октябрь 2011 годов. В последнее время темп роста составил

250000000 серверов в год. Пора подумать о том, чтобы использовать эту мощность, которая превышает возможности всех супер-ЭВМ, для решения

каких-то актуальных проблем.

Рис. 3. Рост числа WEB-серверов по годам

В нашей стране на высшем уровне принято решение о переходе на единое бесплатное программное обеспечение с открытыми кодами.

Но чрезмерная унификация весьма опасна, так как первый же вирус сможет обрушить всю общенациональную сеть. Господь недаром создал нас

с разными генными наборами, иначе первая же эпидемия чумы, холеры или гриппа очистила бы Землю от человечества.

Сетевая безопасность уже давно стала еще одной важной проблемой. 70% часто посещаемых WEB-сайтов содержат вредоносные коды и заражают

посетителей. Рекордный размер botnet достиг 12 млн. машин. Впрочем, самая большая botnet – это совокупность машин с ОС Windows

(ведь мы не знаем, какие программы туда заносятся при автоматическом обновлении ОС).

Емкость памяти современных машин (~1Тбайт) по порядку величины сравнялась с числом нейронов в мозге человека, сигналы в человеческом

теле распространяются со скоростью менее 130м/сек. Машины же выполняют миллион миллиардов операций в секунду, но конкурировать с человеком

при выполнении творческих заданий пока не могут.

Разработчики программного обеспечения стремятся сделать программы более дружественными для пользователя. Но это сопряжено

с усложнение программ. Сформулирован закон Niklaus Wirth, который гласит, что скорость работы новых программ понижается быстрее,

чем увеличивается быстродействие вычислительного оборудования. Усложнение программ делает их уязвимее, а требование к их надежности

растет от дня ко дню.

В 2008 году в мире использовалось 350.000.000 USB-флэш модулей памяти, что создает определенные угрозы.

За последние два года 52% предприятий пострадали от утраты конфиденциальных данных, хранившихся на USB-драйвах.

На рынке появились приборы, которые требуют аутентификации для доступа к таким устройствам. Флэш-память стала причиной занесения

вируса в машины Международной космической станции.

В 2011 году на рынке появился первый квантовый компьютер (128-кубит, Т=0,01 К0) Компьютер занимает площадь 10 кв. метров.

Он умеет распознавать фотографии известных достопримечательностей.

Проблемы

- Семантические сети (искусственный интеллект, контекст и пр.). Неясно, возможно ли решить проблему создания искусственного

интеллекта вообще!

- Разработка надежных алгоритмов распознавание сетевых атак нулевого дня.

- Разработка распределенных систем управления (технологии P2P и GRID) для потенциально опасных технологий (атомная промышленность, оборона)

- Разработка лекарств, индивидуальных для каждого человека.

- Моделирование работы биологических объектов, включая органы человека (например, биомолекул в качестве ячеек памяти (в МГУ)

- Встраивание чипов в живые объекты

- Распознавание мультимедийных образов, создание мультимедийных баз данных и поисковых систем (первые успехи продемонстрировала

компания Google)

- Разработка метаязыка описания проблем (а не алгоритмов), минимизируя участие человека, и, тем самым, числа программных ошибок.

WEB-страница содержит много такого, что не видно при просмотре. Новые технологии обычно сложнее старых, и по этой причине уязвимее.

Каждый час создается 1883 вредоносных кода! (Работа идет без выходных, отпусков и без скидок на кризисы). (Mike Chapple, "Endpoint Security").

Существует огромное множество уязвимостей, большинство из которых связано с программными ошибками. Но некоторые уязвимости связаны

с дефектами алгоритмов или протоколов. Особый класс атак составляют DoS и DDoS. Не брезгуют хакеры и методами социальной инженерии.

Проблема усугубляется тем, что вторжения в сети и машины перешли на коммерческие рельсы.

Основным источником заражения вредоносными кодами стали социальные сети. В 2009 году компания PandaLabs выявила 25 миллионов новых

разновидностей вредоносных кодов (за предыдущие 20 лет было выявлено всего 15 миллионов вредоносных сигнатур). ESET labs регистрирует

более 200.000 новых уникальных вредоносных кодов каждый день.

Рис. 4. Число потенциально опасных WEB-сайтов по годам (1998-2010гг)

Начиная с 2009 года сетевые атаки помимо чисто коммерческих целей, начинают преследовать политические, экономические и военные цели.

Наступление технологического кризиса ИТ к 2020-25 годам достаточно очевидно. Какие выводы мы можем из этого сделать?

Человечество не смирится с ограничениями, и это означает, что в ближайшие годы нас ждут уникальные исследования и прорывы в области ИТ.

Шагами на этом пути можно считать создание супер-ЭВМ Ватсон для работы с текстами на естественном языке и появление коммерческой версии

квантового компьютера.

Компьютер Watson позиционируется как машина, обладающая интеллектом. Она понимает контекст. Машина имеет доступ к 200 миллионам страниц структурированного и

неструктурированного контента (4 террабайта дисковой памяти) 2880 параллельных процессоров Power7 (3,5 ГГц) с памятью 16 террабайт.

Перспективные разработки на ближайшие 10 лет

Ближайшие 10 лет ИТ поменяется радикальным образом. Ниже приведен крайне краткий и, разумеется, неполный список перспективных разработок.

- Программы обеспечения сетевой и информационной безопасности (в том числе для распределенных сетей)

- Искусственный интеллект (машина Watson)

- Мультимедиа базы данных и поисковые системы

- Green computing

- Мультимедиа базы данных и поисковые системы

- Динамичное управление пропускной способностью сети (QoS и оптимизация потоков)

- Новые транспортные протоколы, устойчивые к перегрузкам

- Распределенные системы управления опасными производствами (GRID и P2P)

- Системы распознавания многофакторного состояния системы (атаки нулевого дня, нелегальные задачи легальных пользователей)

- NFC- системы и программы (идентификация и платежные системы)

- Многофакторные системы аутентификации

- Безопасные ОС (число строк кода ОС растет экспоненциально и уже достигло 350 млн)

- Системы управления голосом

- Надежные системы сертификации и верификации программ

- Разработка метаязыка описания проблем (а не алгоритмов), минимизируя участие человека, и, тем самым, числа программных ошибок.

Что же означает кризис ИТ для человечества? В науке и технике кризис обычно является точкой качественного скачка. В начале 20-го века возник кризис физики,

в результате появились теория относительности, ядерная физика и квантовая механика. Найдется работа для всех отраслей науки факультета НБИК:

физика твердого тела, нанотехнология, биологические процессоры и память, искусственный интеллект, и, наконец, сама информатика. Студентам можно позавидовать, их ждет увлекательная работа.

Литература

- http://book.itep.ru/4/7/resources.htm

- Семенов Ю.А. Алгоритмы телекоммуникационных сетей, М. Бином, 2007. 3 т., 1970 стр.

|